Discriminación Artificial

En medio del actual ajetreo internacional por problemas de racismo y desigualdad, se hace necesario hablar de un tema relacionado, importante y preocupante en la misma medida, en cuanto a la inteligencia artificial: diversidad, ética y justicia. Si bien es un tema denso de abordar por la cantidad de conceptos y ciencias relacionadas, me gustaría iniciar este articulo con la definición que Hans Kelsen, jurista y filósofo del siglo XX, da:

“La justicia es aquello cuya protección puede florecer la ciencia, y junto con la ciencia, la verdad y la sinceridad. Es la Justicia de la libertad, la justicia de la paz, la justicia de la democracia, la justicia de la tolerancia.”

A pesar de que hablar de justicia se remonta a eras mitológicas, nuestra historia contemporánea demuestra que aún muchos luchan contra temas tan retrógrados como la creencia de superioridad entre razas y es un privilegio pensar que algo no es un problema porque no nos afecta directamente. Existe un término llamado Kiriarcado, que amplía el patriarcado para abarcar estructuras adicionales de opresión y privilegios como el racismo, capitalismo, supremacía blanca, opresión o cualquier estructura social que se imponga en la cúspide de la “matriz de dominación”. En este sentido, en lo que respecta a ética y justicia en inteligencia artificial, el problema principal es que el punto de partida para toda tecnología siempre tiene que ser la inteligencia e intervención humana.

Suelo comentar una anécdota que desató mí curiosidad en referencia a este tema. En medio de la ronda de preguntas de una conferencia acerca del cambio que están teniendo las organizaciones por la adopción de Inteligencia Artificial en los procesos de reclutamiento, le pregunté al director de recursos humanos de una multinacional importante si no había considerado la posibilidad de perder talento si solo se filtran candidatos por el criterio de algún algoritmo; le expliqué qué, en efecto, pueden de alguna manera no verse representadas todas las cualidades de un individuo en un CV y perderse así de un potencial buen candidato por la forma en el que el algoritmo selecciona a los interesados. Intenté ser lo más explícita posible para dejar en claro mi preocupación con respecto a la manera en la que procesos tan importantes son llevados a ciegas; la respuesta del director a mi pregunta fue: “Si el algoritmo lo dice, pues entonces está bien!! Además, si no lo está, recuerda que la vida no es justa”… Lejos de haber sido un pequeño trago amargo, quedó claro para mí lo peligroso que puede llegar a ser la adopción de instrumentos tecnológicos en la sociedad cuando personas que no entienden el trasfondo, los utilizan para dirigir o tomar decisiones importantes.

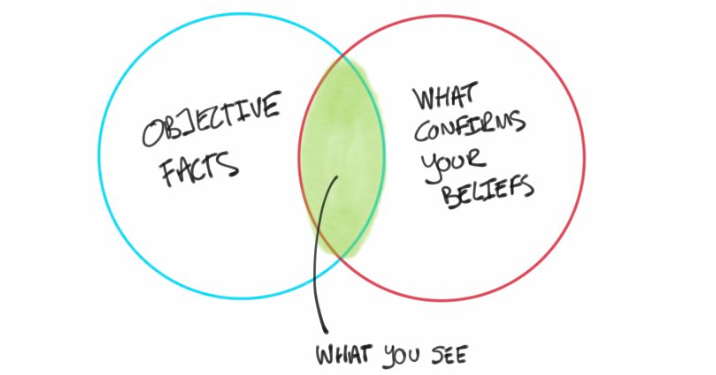

Dicho esto, necesito resaltar que: ¡NO PORQUE UN ALGORITMO LO DIGA, SIGNIFICA QUE ESTÁ BIEN! Los seres humanos somos propensos a cometer errores basados en bias, vemos lo que pensamos y a eso le llamamos objetividad. (En español el término “bias” se traduce como sesgo, pero en el área de la inteligencia artificial la mayor parte de documentación se conseguirá con el término “bias” por lo que continuaremos tratándolo de esta manera).

Hechos objetivos – Lo que ves – Lo que confirma tus creencias. Foto por PaulJ

Siempre que puedo, resalto que la tecnología está tomando decisiones en nuestra vida sin nosotros tener mucha potestad: los anuncios que vemos, como valoran nuestras candidaturas, las rutas de los camiones de basura en los vecindarios, cuantos policías están asignados a nuestro barrio, que película ver primero y una lista interminable de decisiones “aleatorias” que no lo son tanto. En lo personal, soy parte de ese grupo de apasionados de “los algoritmos” y de la magia que percibo por la inteligencia artificial, solo que poco a poco he podido entender que estos sistemas están alimentados por alguna fuente, diseñados por alguna persona, desarrollados por quizás otra y en todas estas etapas podemos afrontarnos a un “bias” inherente a ellas.

Volviendo al tema de la matriz de dominancia, es cierto que, a mayor o menor escala, dependiendo de la ubicación, con mayores o menores consecuencias, los grupos sociales te aceptan o no, por estándares y etiquetas que parecen heredarse de generación en generación. No nos importa tanto de donde venga alguien si esta persona tiene una buena posición económica, en norte-américa nadie protesta contra inmigrantes canadienses o europeos, somos más o menos amigables con otro dependiendo de su partido político y cuántos muchos otros ejemplos tienen lugar en este apartado, que al final son determinantes en nuestras decisiones y modos de operar.

Les pido que por favor recuerden, aprendan y sean curiosos con el término “AI BIAS”, como si su vida fuese a depender de ello. En el campo de la inteligencia artificial muchos expertos coinciden en que este término se refiere al momento en el que un sistema informático refleja los valores implícitos de los humanos que lo crearon.

“El objetivo del AI es explicar tus deseos a una computadora utilizando ejemplos (datos!). ¿Qué ejemplos? eso es de tu elección como profesor. Los Datasets son como los libros de textos de dónde tus estudiantes aprenden… Los libros de textos reflejan el sesgo de sus autores y al igual que estos, los Datasets tienen autores.” – Rahul Agarwal.

Quedémonos con la idea de que los Datasets con los que nuestros algoritmos aprenden o deciden que hacer, son como los libros con los que aprendemos durante nuestra vida, evidentemente habrá algún efecto dependiendo de a quién leemos. Recordemos también que los algoritmos de AI/ML son herramientas configuradas y entrenadas por lo que nosotros decidamos. Si los entrenamos con ciertos datos, responderán a dichos datos, si los configuramos de cierta forma, seguirán dicha forma. Por tanto, el bias en estos casos no viene del algoritmo, sino de las personas detrás de él.

A continuación, se presentan varios ejemplos que se han hecho públicos y son bastante resonantes, de fallos percibidos por el uso de AI con Bias:

- “Millions of black people affected by racial bias in health-care algorithms” https://www.nature.com/articles/d41586-019-03228-6. Este estudio concluyó que el algoritmo que utilizaban muchos centros de salud tenía menos probabilidades de referir a personas afroamericanas que a personas blancas que estaban igualmente enfermas, a programas que apuntan a mejorar la atención de pacientes con necesidades médicas complejas.

- Artificial Intelligence Has a Problem With Gender and Racial Bias https://time.com/5520558/artificial-intelligence-racial-gender-bias/ . Es un artículo hecho por JOY BUOLAMWINI, activista en la lucha contra el AI Bias y a quien sigo con detenimiento, el cual comenta que en el 2015 algún software de análisis facial no pudo detectar su cara de piel oscura, sino hasta que utilizó una máscara blanca. Observen como en la siguiente imagen, el software de reconocimiento facial de Amazon, Microsoft, and IBM, entrega muchísimos mejores para hombres de piel blanca sobre cualquier otro grupo.

- Amazon reportedly scraps internal AI recruiting tool that was biased against women. https://www.theverge.com/2018/10/10/17958784/ai-recruiting-tool-bias-amazon-report. En este caso, el algoritmo de ML utilizado en el software de reclutamiento de Amazon, penalizaba a los solicitantes que asistían a universidades meramente de mujeres, así como a cualquier CV que contuviera la palabra “mujer”. (Este artículo va en especial para mi amigo director de RRHH)

- Flawed Criminological Software (COMPAS, Correctional Offender Management Profiling for Alternative Sanctions). Es un algoritmo utilizado en los sistemas judiciales estatales en todo Estados Unidos usado para predecir la probabilidad de una reincidencia criminal; los acusados afroamericanos tenían casi el doble de probabilidades de ser clasificados erróneamente con un mayor riesgo de reincidencia (45%) en comparación con sus homólogos blancos (23%).

- Se han determinado casos de “Word Embeddings” (incrustaciones de palabras), que soportan herramientas como el completado automático y el traductor de Google, los cuales generan analogías útiles como Roma::Italia -> Madrid::España, pero también generan analogías no tan útiles cómo: Hombre::Programador à Mujer::Ama de casa.

Esto son casos conocidos de un pool bastante amplio de fallos en herramientas de inteligencia artificial asociados a discriminación, racismo o injusticias. En este momento de transformación, en el que muchas empresas están intentando implementar sistemas inteligentes en casi todas sus operaciones, es de prioridad urgente conocer los riesgos inherentes y trabajar en reducirlos.

La falta de representación de un grupo conduce a conjuntos de datos sesgados y a algoritmos que tienen muchas más probabilidades de crear sesgos sistémicos. Imaginen que sólo un prototipo de persona, por ejemplo, un amante del sushi es responsable del desarrollo, capacitación y despliegue de un sistema de recomendación de comida; a pesar de que nuestro desarrollador tiene buen gusto y sepa existen otros tipos de comida también deliciosos, sus gustos personales inevitablemente le inclinaran por una cultura gastronómica, lo que finalmente no será un grupo representativo de la sociedad en general. Defiendo que todos tenemos creencias, gustos y puntos ciegos diferentes, pero debido a que “son diferentes” la diversidad nos permite identificar mejor estos bias o vacíos involuntarios de nuestra percepción, es por ello que, todos debemos formar parte en la creación, adopción y transformación del mundo hacia la era de la inteligencia artificial.

A pesar de que no podamos predecir con certeza cuan rápido se automatizarán todos los procesos de nuestra vida, si es propicio admitir que cada vez cobra mayor relevancia la justicia en el ámbito del AI y existe una clara preocupación internacional en los efectos de esta, a la medida en que va tomando fuerza en nuestra sociedad. Para cerrar las ideas, introduzco el término “Neutralidad Tecnológica”, para el cual Axel Andorff, vicepresidente de I+D de SEAT, menciona que:

“La propiedad de la neutralidad tecnológica parte de la idea de que la realidad va siempre por delante de la regulación, lo cual se refleja especialmente en un entorno digitalizado y cambiante como en el que vivimos. …Es decir, que la regulación debe focalizarse más en los efectos de las propias acciones, en lugar de en las acciones y los medios por sí mismos.”

Tenemos ante nosotros el reto de establecer un nuevo contexto de cooperación con el objetivo de desarrollar herramientas de inteligencia artificial basadas en diversidad, inclusión, justicia, aceptación y bien colectivo. Para ello es primordial entender que nuestro sistema presenta fallos que son heredados y necesitamos combatirlos generando oportunidades e involucrando a todos los perfiles posibles en cada etapa del desarrollo de estas herramientas. Seamos curiosos, seamos partícipes activos, utilicemos nuestros talentos y habilidades para involucrarnos en toda clase de proyecto de transformación que podamos, a la medida en que entendamos la relevancia de esta etapa, podremos generar un cambio simbólico a nivel cultural, que se verá reflejado en un futuro más justo para todos.

Entiendo es un tema controversial, más me conformo con que mi artículo de opinión despierte alguna especie de curiosidad.

Excelente. No imaginé que sistemáticamente existiesen discriminaciones de algún tipo.